Nel 2011 ho acquistato un televisore Samsung 46 pollici, modello ES8000 (ne ho già parlato, per un problema, in questo articolo). Per potere giocare con le diverse app installate, ho montato su di esso una chiavetta USB. Nel corso degli anni abbiamo registrato su di essa diverse foto e video, fatti con la camera integrata. Ad un certo punto, il buio. Chiavetta non riconosciuta. Provo ad accedere ai dati, nulla. Non viene vista da Linux nè da Windows. Ok, mi incaponisco. Questo il risultato.

Inserendo la chiavetta in un calcolatore linux, si ottengono pochissime informazioni. sd 4:0:0:0: [sdd] 2041856 512-byte logical blocks: (1.05 GB/997 MiB)

sd 4:0:0:0: [sdd] Write Protect is off

sd 4:0:0:0: [sdd] Mode Sense: 23 00 00 00

sd 4:0:0:0: [sdd] Write cache: disabled, read cache: enabled, doesn't support DPO or FUA

sd 4:0:0:0: [sdd] Attached SCSI removable disk

Che sono comunque utili a determinare il funzionamento del dispositivo. In rete ho trovato la documentazione di un progetto “SamyGO“, che parla del filesystem di queste chiavette. Si tratta di un RFS, Robust File System, pensato proprio per le pendrive e supportato da Samsung “da sempre”. Rimane da capire come accedere ai dati, cosa che viene spiegata in questo articolo: in pratica si tratta di un filesystem FAT16 o FAT32, che può essere montato nativamente e con poco sforzo in linux. Il problema è, semmai, recuperare i dati della partizione.

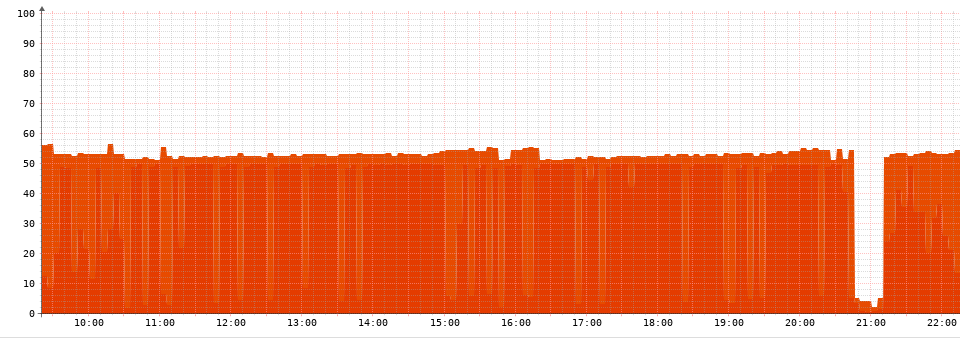

Come già successo in passato, mi è venuto in aiuto il programma testdisk (lo avevo usato per recuperare i dati di “esse”) , in ambiente linux. Ho caricato il drive corrispondente alla mia chiavetta (/dev/sdd) ed ho provato a fare riconoscere la partizione: NULLA. Allora ho deciso di lavorare “senza partizioni” indicando un filesystem di tipo FAT16 ed eseguendo una “immagine della partizione”. Ho fatto lo stesso con il filesystem FAT32.

Una volta create le “immagini” mi sono messo a lavorare con queste.

testdisk image16.dd

selezionare “proceed” e quinti “non partitioned media”

associare un tipo fat16 ai dati

eseguire un “rebuild del boot sector”

Con l’opzione “list” è possibile vedere tutti i files che sono recuperabili (in grigio) e quelli persi per sempre (in rosso).

Con una sintassi molto fantasiosa (utilizzo di : e C) è possibile copiare i dati in una altra posizione e, finalmente, goderseli.

Una ultima nota: Samsung salva le immagini in formato ljpg, che è un jpg a tutti gli effetti. I video hanno estensione .vu, ma VLC li “digerisce” senza problemi in quanto sono MPEG.

Finalmente posso regalare a questa chiavetta, il riposo eterno che merita!